A veces nos encontramos en grandes empresas con numerosos portales que con el paso del tiempo se han vuelto obsoletos y se han cerrado sin que su contenido este aprovechado para migrarlo a otro portal o bien sin redirigir con 301 las URLs para transferir el peso SEO de sus backlinks a otro dominio.

Aquí no vamos a tratar el tema de las redirecciones, sino la posibilidad de recuperar años después algún contenido único y de valor que podían tener estos portales antiguos para aprovecharlos y publicarlos en nuevos portales.

La cuestión es entonces de saber cómo copiar el contenido archivado por Way Back Machine (WBM) o Web Archive: http://web.archive.org/ dado que aspiradores de sites como WinHTTrack Website Copier no funcionan con WBM porque el robots.txt bloquea el rastreo y la indexación de sus páginas.

Para conseguir copiar el contenido archivado de WBM debemos seguir estos pasos:

1/ Conseguir URL inicial:

Ejemplo: http://web.archive.org/web/*/http://dominio.com

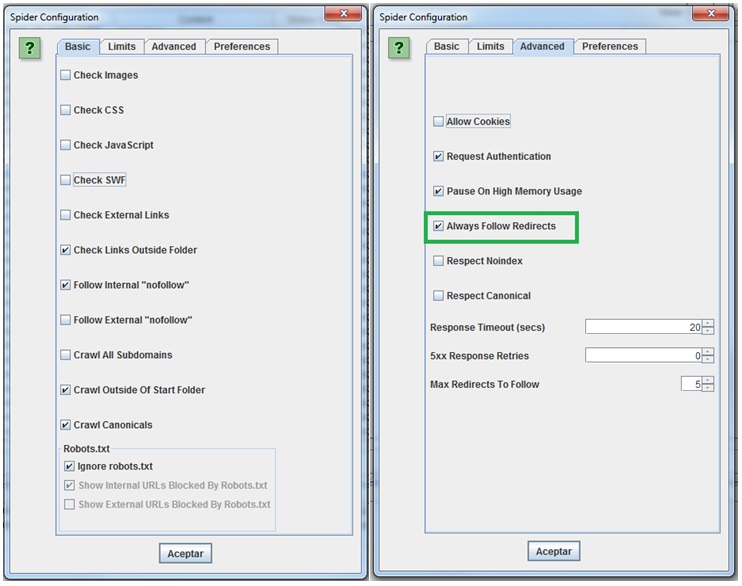

2/ Configurar el Spider Screaming Frog de la siguiente manera:

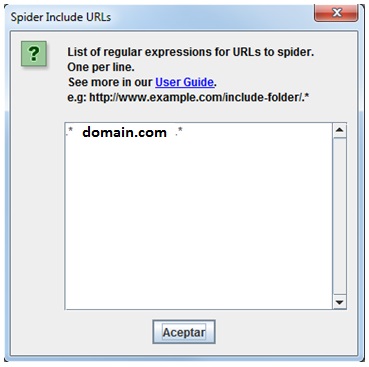

3/ Añadir filtro de URL “Include” para rastrear solo el dominio que nos interesa:

Si el número de páginas es demasiado elevado y Screaming Frog se queda sin memoria, realizar un crawl por año, usando la URL del año y añadiendo un filtro de URL “Include”:

http://web.archive.org/web/20100601000000*/http://dominio.com

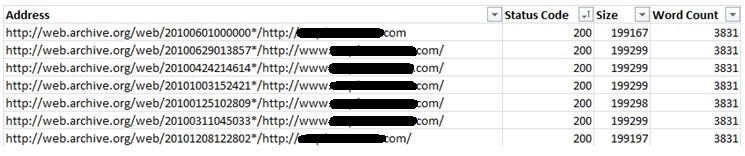

4/ Extraer URLs:

Extraer URLs internas con respuesta 200 y ordenar por número de palabras encontradas. Quitar del listado las URLs con “*/” dado que no son URLs del dominio analizado sino propias de WBM que no nos interesan para extraer el contenido (suelen tener un volumen importante de palabras contadas):

5/ Extraer contenido a partir de las URLs validas con iMacros:

a) Instalar Firefox y el complemento iMacros: https://addons.mozilla.org/es/firefox/addon/imacros-for-firefox/

b) En caso de fallos de memoria de Firefox, instalar también el complemento www.browsermemory.com que limpia la cache de Firefox en continuo.

c) Crear un script similar a este para que a partir de un listado de URLs iMacros vaya copiando y almacenando el contenido de las páginas en archivos TXT, HTML y eventualmente JPG:

VERSION BUILD=6900210

SET !ERRORIGNORE YES

SET !TIMEOUT_STEP 0

SET !TIMEOUT_PAGE 15

SET !EXTRACT_TEST_POPUP NO

FILTER TYPE=IMAGES STATUS=ON

SET !ERRORIGNORE YES

CMDLINE !DATASOURCE C:\Users\BR\Documents\iMacros\Macros\List-URL-a-copiar.txt

SET !DATASOURCE_COLUMNS 1

SET !DATASOURCE_LINE {{!LOOP}}

TAB CLOSEALLOTHERS

TAB T=1

‘PROXY ADDRESS=206.214.93.35:8800

URL GOTO={{!COL1}}

WAIT SECONDS=20

SAVEAS TYPE=TXT FOLDER=C:\Users\BR\Documents\iMacros\Macros\Copypages\TXT\ FILE={{!COL1}}.txt

WAIT SECONDS=5

SAVEAS TYPE=HTM FOLDER=C:\Users\BR\Documents\iMacros\Macros\Copypages\HTM\ FILE={{!COL1}}

WAIT SECONDS=5

SAVEAS TYPE=JPEG FOLDER=C:\Users\BR\Documents\iMacros\Macros\Copypages\JPEG\ FILE={{!COL1}}

WAIT SECONDS=10

URL GOTO=https://www.google.es/

WAIT SECONDS=1

CLEAR

d) Pegar URLs en el archivo List-URL-a-copiar.txt y ejecutar en bucle tantas veces como hay de URLs.

6/ Comprobar el contenido duplicado para quedarnos con el contenido único utilizable en nuestros portales nuevos:

Para ello, utilizaremos una cuenta de pago http://www.copyscape.com/ que permite exportar un índice de % de contenido duplicado por cada contenido que subamos.